韓国のコミュニティサイトより「」というスレの反応を翻訳して紹介します。

・小学校の授業発表中に「びっくり」…教師を戸惑わせた子どもの自信

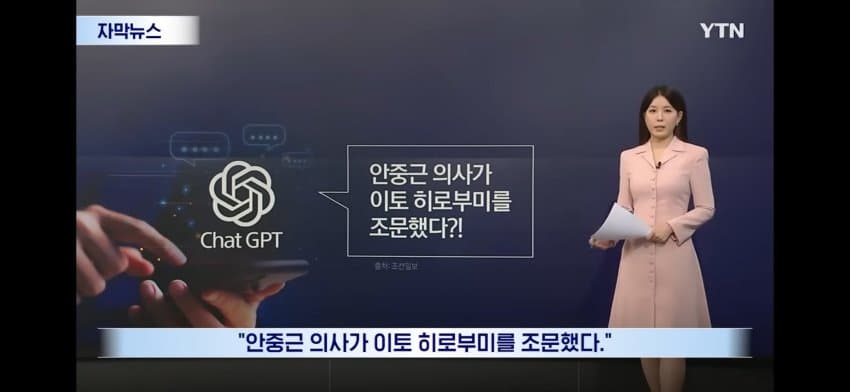

「安重根義士が伊藤博文を弔問した。」

突拍子もない話のようですが、ソウルのある小学校の社会の授業で出た発表内容だといいます。

生成型AIが作った誤った回答を、児童がそのまま信じて発表したということです。

内容が間違っているという教師の指摘にも、「ChatGPTがどうして間違うんですか」という問い返しがあったといいます。

AIが日常になった教室の中で、AIの回答を検証の対象ではなく「正解」として受け入れる児童が増え、懸念が高まっています。

ソウル市教育庁が昨年、全国の教師3,300人あまりを対象に調査した結果、10人のうち9人以上が「学生がAIの教える内容を批判なく受け入れることが懸念される」と答えました。

これに加え、AIが正しい情報を与えても、きちんと読まずに誤読するケースも少なくありません。

文章をきちんと読まず、見たい部分だけを読んで判断を終えてしまうのです。

問題は、このようなAI依存症が、学生たちの基本的な情報判断能力まで退化させているという点です。

わが国の学生たちの現実は、さらに深刻です。

OECDが発表した資料によると、事実と意見を区別できる韓国の15歳の学生の割合は25.6%で、OECD平均の半分水準の最下位圏でした。

中学生4人のうち3人は、与えられた文章の情報が本物か偽物かを判断できないという意味です。

専門家たちは解決策をはっきりと述べます。

AIを使う前に、「読む訓練」からすべきだということです。

結局、読まず、考えないAIの「使い方」が問題だというのです。

今、教室で急がれるのは、もしかするとAIの使い方よりも、本であれ、新聞であれ、文脈を追いながら読む経験ではないでしょうか。

コメント掲示板はコチラ

ttps://x.gd/tlhFp

韓国の反応

今さらだろう。

掲示板で議論してると、事実と願望を区別できない人がかなり多い。

社会全体の問題だろう。

だからGPTの情報が本当かどうか見抜けない。

大人も同じ。

社会全体がそんな状態。

だから集団心理に流されやすい。

それで何度も失敗すると、今度はすべてを疑うようになる。

情報を貰ったら、無条件で信じるか、無条件で疑うかの両極端なんだよ。